ประเด็นคำถามเรื่อง ‘อคติเอนเอียง’ และ ‘ความโปร่งใส’ ในกระบวนการยุติธรรมนั้นมักถูกจับตามองโดยสังคมเสมอเวลามีเหตุสะเทือนใจเกิดขึ้น ไม่ใช่เพราะมนุษย์มีความชื่นชอบในทฤษฎีสมคบคิดที่ดูน่าตื่นเต้นในหนัง แต่เพราะมันเป็นสิ่งที่เกิดขึ้นจริงๆ ทั่วโลก (ไม่ใช่แค่บ้านเราเท่านั้นนะ) ยกตัวอย่างเหตุการณ์สลดใจที่ จอร์จ ฟลอยด์ (George Floyd) ชายแอฟริกัน-อเมริกันถูกเจ้าหน้าที่ตำรวจในเมืองมินนีแอโพลิส ทำร้ายร่างกายเอาหัวเข่ากดไปที่คอจนขาดอากาศหายใจเสียชีวิต เพียงเพราะว่าเสมียนร้านค้าสงสัยว่าฟลอยด์อาจใช้ธนบัตรปลอมมูลค่า 20 ดอลลาร์สหรัฐฯ เมื่อวันที่ 25 พฤษภาคม ค.ศ.2020

เรื่องของฟลอยด์จุดประเด็นปัญหาที่ฝังรากลึกในสังคมของเรามายาวนานให้คนหันกลับมาสนใจอีกครั้ง ปัญหาของการเหยียดสีผิว แบ่งชนชั้น และไม่เท่าเทียมที่ถูกกระทำโดยเจ้าหน้าที่ที่สาบานตนว่าเป็น ‘ผู้พิทักษ์รับใช้และปกป้องประชาชน’ แต่กลับเลือกที่รักมักที่ชัง รับใช้และปกป้องประชาชนแค่ ‘บางคน’ เท่านั้น จนทำให้เกิดการประท้วงและออกมาเคลื่อนไหวของผู้ที่ไม่เห็นด้วย ต้องการเรียกร้องความเป็นธรรมให้เกิดขึ้น ตั้งคำถามกับกระบวนการทำงาน ความโปร่งใส และอคติที่ตำรวจหรือเจ้าหน้าที่ทางกฏหมายมีต่อประชาชนทุกคนว่าสมควรแล้วหรือไม่

แล้วจะเกิดอะไรขึ้นถ้าตำรวจมี AI

เป็นเครื่องมือช่วยเหลือในด้านอาชญากรรม

การทำงานของผู้พิทักษ์สันติราษฎร์

จะไร้ความเอนเอียงและโปร่งใสขึ้นหรือเปล่า?

การมาถึงของเทคโนโลยี AI

ถ้าใครเคยดูหนังเรื่อง Minority Report ที่พระเอกเป็นตำรวจในอนาคตทำหน้าที่สกัดกั้นอาชญากรรมที่ยังไม่เกิดขึ้น จับตัวคนร้าย(ที่ยังไม่ได้ทำผิด)ไปเข้าคุก เพราะระบบบอกว่านั่นคือสิ่งที่คำนวณออกมาแล้ว เราซึ่งเป็นผู้ชมก็ได้แต่ทึ่งและเหลือเชื่อกับเรื่องราวสุดล้ำในหนังไซ-ไฟ แต่ในปัจจุบันที่เทคโนโลยี AI (artificial intelligence) นั้นพัฒนาแบบก้าวกระโดด AI ถูกนำมาใช้เพื่อสร้างเครื่องมือที่มีความสามารถคล้ายคลึงกับระบบที่อยู่ในหนังไซ-ไฟ โดยให้คำมั่นสัญญาว่าจะช่วยปกป้องเราจากเหตุร้ายๆ ‘ก่อน’ ที่มันจะเกิดขึ้น

โดยระบบนี้จะติดตามและวิเคราะห์ข้อมูลจำนวนมหาศาลเพื่อคาดเดาว่าใครที่มีโอกาสจะก่ออาชญากรรมในอนาคต ระบบ AI จะถูกป้อนข้อมูลจากเหตุอาชญากรรมที่ผ่านมาเพื่อทำนายสิ่งที่จะเกิดขึ้น ข้อมูลยิ่งดีและแม่นยำแค่ไหน การคาดเดาก็จะยิ่งชัดเจนมากและแม่นยำมากขึ้นเท่านั้น มีคำศัพท์ทางคอมพิวเตอร์อันหนึ่งที่บอกว่า ‘GIGO’ หรือ Garbage In, Garbage Out ที่มีความหมายว่าถ้าป้อนขยะเข้าไป ก็จะได้ขยะออกมา แล้วถ้าตำรวจเป็นคนป้อนข้อมูลเหล่านี้ ข้อมูลเหล่านี้มีอคติที่ติดเข้าไปอยู่แล้ว สุดท้าย AI ที่ออกมาก็ยิ่งทำให้ความไม่เท่าเทียมนั้นฝังรากลึกและติดแน่นลงไปกว่าเดิมอีกนั่นเอง

ยกตัวอย่างง่ายๆ ว่า คนผิวดำมีโอกาสมากกว่าคนผิวขาวที่จะถูกรายงานว่าก่อเหตุผิดกฏหมาย ไม่ว่าคนสีผิวไหนเป็นคนโทรรายงานเรื่องนั้น ซึ่งก็ทำให้ชุมชนพื้นที่คนผิวดำถูกจับตามอง เพราะฉะนั้นในพื้นที่ของชุมชนที่คนผิวสีอาศัยอยู่เยอะก็จะกลายเป็นพื้นที่ ‘เสี่ยงสูง’ โดยทันทีในอัตราส่วนที่บิดเบี้ยว

การใช้ข้อมูลเพื่อตรวจจับและขีดแบ่งพื้นที่แบบนี้ไม่ใช่เรื่องใหม่ ที่จริงมันเกิดขึ้นก่อนตั้งแต่ยุค 90s โดยเป็นความพยายามของหน่วยงานตำรวจที่อยากจะชี้เป้าว่าพื้นที่ตรงไหนคือพื้นที่ ‘เสี่ยงสูง’ ที่มีการเหตุร้ายเกิดขึ้นบ่อยๆ ซึ่งแนวคิดนี้ที่จริงฟังดูไม่ได้แย่ในตัวมันเอง เพราะถ้าเราสามารถวางจุดได้ว่าตรงไหนที่มีความเสี่ยงในการเกิดเรื่องไม่ดี ตำรวจก็สามารถทุ่มทรัพยากรให้มีการตรวจตราหนักขึ้นในพื้นที่นั้นๆ

ปัญหาอยู่ตรงที่ว่า ตำรวจมี ‘อคติ’ และ ‘ความไม่เท่าเทียม’ ฝังอยู่แล้วในตัว เมื่อไปตรวจตราขับรถวนอยู่ในบริเวณนั้น ก็ทำให้ยิ่งมีรายงานจำนวนคดี ‘มากขึ้น’ ไปด้วย ซึ่งเป็นเหมือน feedback loop ที่บิดเบือนภาพของบางพื้นที่และสังคมให้ต่างจากความเป็นจริง และเมื่อตำรวจเหล่านี้ถูกส่งไปยังพื้นที่นิยามว่าเสี่ยงเยอะขึ้น รายงานเหตุร้าย (ซึ่งอาจจะเป็นเพียงแค่ความสงสัยว่าคนคนนั้นจะทำผิดเหมือนอย่างฟลอยด์) ก็มากขึ้น ยิ่งทำให้พวกเขาคิดว่าแถวนี้อันตราย และส่งตำรวจเพิ่มเข้าไปอีก

นำไปสู่ประเด็นถกเถียงที่ยังไม่จบว่า จำนวนของตำรวจที่มากขึ้นนี้ในพื้นที่เหล่านี้กลายเป็นสร้างสภาพแวดล้อมแบบรัฐตำรวจ (police state) ที่ฝ่ายปกครองมีอำนาจในการใช้ดุลพินิจแบบสมบูรณ์ เจ้าหน้าที่ของรัฐสามารถกำหนดมาตรการทางกฎหมายเพื่อใช้บังคับประชาชนตามเห็นสมควร เป็นอิสระตามสถานการณ์และให้บรรลุเป้าหมายของรัฐที่วางเอาไว้ โดยไม่สนใจวิธีการ (means) เลย ในสถาณการณ์แบบรัฐตำรวจประชาชนจึงตกอยู่ในความเสี่ยงที่จะถูกกระทำตามอำเภอใจของรัฐและเจ้าหน้าที่ของรัฐได้ แทนที่จะใช้เงินที่จ้างตำรวจมาลาดตระเวนในพื้นที่มากขึ้น ควรไปเพิ่มเงินสนับสนุนเพื่อดูแลด้านสุขภาพจิตหรือบริการสังคมอื่นๆ จะช่วยสนับสนุนชุมชนเหล่านี้ได้ดีมากกว่า

เมื่อเครื่องมือเหล่านี้ถูกป้อน ‘ข้อมูล’ เหล่านี้เข้าไป

เพื่อสร้างเป็นระบบคาดเดาออกมา

มันก็จะดึงเอา ‘อคติ’ เหล่านี้มาด้วย

ยิ่งตอกย้ำความเชื่อที่ผิดว่าพื้นที่เหล่านี้คือพื้นที่ ‘เสี่ยงสูง’ มากขึ้นไปด้วย

อีกปัญหาหนึ่งของแนวคิดใช้ AI นี้ คือ การอาศัยข้อมูลในอดีต แม้ว่าอดีตอาจจะพอเป็นเบาะแสแก่พฤติกรรมในอนาคต แต่มันก็ไม่ได้คำนึงถึงการเปลี่ยนแปลงของบุคคลและระบบฟื้นฟูที่ช่วยให้คนที่อาจจะเคยทำผิดแล้วกลับตัวกลับใจใหม่ ส่งผลทำให้ตอกย้ำความคิดเห็นเชิงลบต่อบุคคลเหล่านั้น และไม่สามารถหลุดออกจากวังวนที่ถูกลงโทษซ้ำแล้วซ้ำเล่า ทั้งๆ ที่พวกเขารับผิดในส่วนที่กระทำลงไปแล้ว พูดอีกอย่างหนึ่งก็คือ เมื่อทำผิดครั้งหนึ่ง (ไม่ว่าจะเป็นความผิดพลาดหรือด้วยเหตุใดก็ตาม) ระบบก็จะติดธงแดงให้คุณไปตลอดกาล

ในขญะที่หน่วยงานตำรวจทั่วโลกกำลังพัฒนาระบบซอฟต์แวร์เพื่อระบุอาชญากรรมที่กำลังจะเกิดขึ้น ในขณะที่มีบริษัทเทคโนโลยีของอเมริกาหลายสิบแห่งที่ขายซอฟต์แวร์ประเภทนี้ให้กับหน่วยงานที่บังคับใช้กฎหมาย มีบริษัทหนึ่งชื่อว่า Voyager Labs ซึ่งเป็นบริษัทสตาร์ตอัพที่รวบรวมข้อมูลโซเชียลมีเดีย รวมถึงโพสต์บนเฟซบุ๊ก อิโมจิต่างๆ เพื่อนๆ ที่อยู่ในวงออนไลน์เดียวกัน หลังจากนั้นก็เอาข้อมูลทั้งหมดมาวิเคราะห์เพื่อเชื่อมต่อ แถมยังโยงข้อมูลนี้ไปกับข้อมูลส่วนตัวเพื่อสร้างโปรไฟล์ ‘แบบองค์รวม’ ที่สามารถใช้เพื่อค้นหาบุคคลที่ก่อให้เกิด ‘ความเสี่ยง’ ได้อีกด้วย

ความไม่เที่ยงตรงและเอนเอียงในระบบ AI

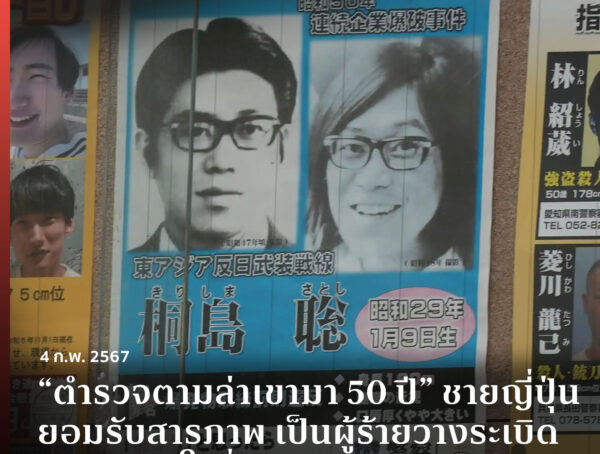

เราเห็นรายงานข่าวหลายครั้งที่ระบบตรวจสอบอัตโนมัตินั้นมักทำงานได้อย่างไม่ถูกต้องนัก ยกตัวอย่างรายงานจากหนังสือพิมพ์ Independent ในปี ค.ศ.2018 ที่ระบบของตำรวจนครบาลแจ้งเตือนว่าพบเจอบุคคลต้องสงสัยที่เคยก่ออาชญากรรมมาถึง 104 ครั้ง โดยมีเพียงสองครั้งเท่านั้นที่ได้รับการยืนยันในภายหลังว่าข้อมูลถูกต้อง เอ็ดเวิร์ด ซานโตว์ (Edward Santow) เขียนไว้ใน The Australian Quarterly เกี่ยวกับประเด็นนี้ว่า

“ตั้งแต่วินาทีที่เจ้าหน้าที่ตำรวจระบุตัวผู้ต้องสงสัยไม่ถูกต้อง จนถึงช่วงเวลาที่เจ้าหน้าที่ตระหนักถึงความผิดพลาดของพวกเขา เหตุการณ์ที่ใช้กำลังบีบบังคับอาจจะเกิดขึ้นไปแล้ว ผู้ต้องสงสัยสามารถถูกจับ ถูกนำตัวไปที่สถานีตำรวจ และถูกควบคุมตัว มันเป็นเรื่องน่าสะพรึงกลัวที่ส่งผลลัพธ์ที่แก้ไขไม่ได้ รวมถึงยังเป็นการละเมิดสิทธิมนุษยชนด้วย”

นอกจากนี้ ระบบจดจำใบหน้า (facial recognition) ยังแสดงให้เห็นถึงอคติต่อคนผิวสี ในตัวอย่างหนึ่งที่แสดงให้เห็นถึงความเลวร้ายนี้ ที่อัลกอริธึมการจดจำใบหน้าของเฟซบุ๊กระบุว่า คนผิวดำเป็น ‘ลิง’ ทางบริษัทเองก็ออกมายอมรับว่ามัน “เป็นข้อผิดพลาดที่ไม่สามารถยอมรับได้” และจะมีการตรวจสอบระบบให้ดีขึ้นเพื่อไม่ให้มันเกิดขึ้นอีก

เมื่อไม่มีคนคอยดูแลระบบยิ่งทำให้อันตราย

เมื่อมีระบบอัตโนมัติเข้ามาช่วย การดูแลควบคุมโดยมนุษย์ก็น้อยลง พอหน่วยงานทางกฎหมายเริ่มพึ่งพาเครื่องมือเหล่านี้มากขึ้น ตัวเครื่องมือก็เริ่มมีอำนาจมากขึ้นด้วย คำตัดสินหรือคาดเดามักไม่ก่อให้เกิดการตั้งคำถามใดๆ ซึ่งในรายงานที่เขียนขึ้นโดย เคต ครอว์ฟอร์ด (Kate Crawford) และ เจสัน สชัลซ์) Jason Schultz ชื่อ ‘AI Systems as State Actors’ เรียกเหตุการณ์แบบนี้ว่า ‘accountability gap’ หรือ ‘ช่องว่างของความรับผิดชอบ’ ที่ส่งผลให้ทั้งพนักงานที่เป็นมนุษย์ทั้งของรัฐและเอกชนมีแทบไม่รู้เลยว่ามีกระบวนการตัดสินใจเกิดขึ้นมาได้ยังไง หรือพูดอีกอย่างหนึ่ง คือ เราจะไว้วางใจ AI และไม่รู้เลยว่าเบื้องหลังของมันทำงานยังไงนั่นเอง เพราะเมื่อระบบเหล่านี้อาจจะมาจากหลายๆ แห่ง รัฐอาจจะสร้างเอง เอกชนทำ หรือมีใครสักคนอยากช่วยเหลือและบริจาคมาก็ไม่มีทางรู้ ข้อมูลเหล่านี้ซึ่งเป็นเบื้องหลัง แม้บิดเบือนไม่ถูกต้องเพียงเล็กน้อยก็ส่งผลกระทบมหาศาลตามมาได้

มีโครงการหนึ่งที่สร้างขึ้นมาโดยความร่วมมือระหว่างมหาวิทยาลัยโคลัมเบียกับสถาบัน AI Now และ New York University School of Law’s Center on Race, Inequality, and the Law, and the Electronic Frontier Foundation และ มูลนิธิ Electronic Frontier Foundation ที่เริ่ม ‘ดำเนินการตรวจสอบการดำเนินคดีในอเมริกา ที่รัฐบาลใช้อัลกอริธึมเป็นศูนย์กลางในเรื่องของสิทธิและเสรีภาพที่เป็นประเด็นในคดีเหล่านี้’ ในรายงานนี้นักวิจัยเน้นไปที่เหตุการณ์ที่มีการใช้ AI ในการบังคับใช้ทางกฎหมาย อย่างเช่น โครงการประกันสุขภาพและสวัสดิการด้านทุพพลภาพ การประเมินครูในโรงเรียนของรัฐ และการประเมินความเสี่ยงทางอาญา ในกรณีเหล่านี้นักวิจัยจะดูว่า มนุษย์ใช้งาน AI แบบไหน โดยสรุปออกมาได้ว่า ระบบ AI เหล่านี้ถูกนำไปใช้โดยไม่มีการฝึกอบรม การสนับสนุน หรือการกำกับดูแล และไม่มีการป้องกันดูแลแก่ผู้รับผลประโยชน์เลย ส่วนหนึ่งเนื่องมาจากที่ว่าระบบถูกนำมาใช้เพื่อประหยัดต้นทุน ซึ่งไม่คำนึงถึงความรับผิดชอบที่ตามมา

“ระบบ AI พึ่งพาการเรียนรู้จากข้อมูลมากขึ้น ความเป็นไปได้ คือ มันจะเป็นระบบอัตโนมัติและเข้าใจยากมากขึ้นไปด้วย ทำให้ช่องว่างของความรับผิดชอบสำหรับการละเมิดรัฐธรรมนูญกว้างขึ้นและลึกขึ้นด้วย”

นำมาซึ่งคำถามที่ว่าแล้วบริษัทซอฟต์แวร์หรือผู้ผลิตระบบเหล่านี้ต้องเข้ามารับผิดชอบแค่ไหน? หรือเอาถ้าจะถามให้ถูกคือจะรับผิดชอบอย่างไรมากกว่า? เพราะเมื่อระบบเหล่านี้ถูกปล่อยออกมาสู่สาธารณะเพื่อใช้งาน มนุษย์ก็จะปล่อยให้มันทำงานโดยไม่ตั้งคำถามมากขึ้น เพราะฉะนั้นถ้าเกิดความผิดพลาดขึ้นมา บริษัทเหล่านี้ควรเข้ามารับผิดชอบของผลจากการกระทำของผลิตภัณฑ์ที่ตัวเองสร้างขึ้น แต่กฎหมายตรงนี้ก็ยังไม่ชัดเจนว่าต้องทำอย่างไร เพราะเจ้าหน้าที่ของรัฐเองก็ไม่ได้มีความรู้เรื่องของเทคโนโลยีหรืออธิบายที่สิ่งที่เกิดขึ้นได้ แล้วจะตอบว่า “เราไม่สามารถรับผิดชอบต่อสิ่งที่เราไม่เข้าใจ” ก็ดูเหมือนจะไร้ความรับผิดชอบเกินไปสักหน่อย ซึ่งถ้ายังตอบไม่ได้ว่าใครจะรับผิดชอบ ก็ไม่ควรนำมันออกมาใช้ตั้งแต่แรก

ในประเทศที่รัฐควบคุมทุกอย่าง (เช่น ประเทศจีน) ปัญหานี้เป็นสิ่งที่แทบจะทำอะไรไม่ได้ เอกชนสร้างระบบขึ้นมาขายให้รัฐบาลและประชาชนเองก็ไม่สามารถมีปากเสียงอะไรได้ อย่างน้อยในประเทศอื่นๆ ที่ปกครองโดยระบบประชาธิปไตย กฏหมายยังคงพอปกป้องและดูแลประชากรของประเทศอยู่บ้าง สิ่งที่เราควรทำคือต้องติดตามเรื่องราวเหล่านี้เอาไว้ การสอดส่องข้อมูลประชาชนโดยบอกว่า ‘เพื่อความมั่นคง’ และปลอดภัยของตัวท่านเองนั้นดูไม่ต่างอะไรจากฝังความคิดในหัวไม่ให้เราตั้งคำถาม (ก็มันเป็นประโยชน์ของคุณไง เราถึงต้องเข้าถึงข้อมูลส่วนตัวและสอดส่องทุกการเคลื่อนไหว) ซึ่งไม่ควรเกิดขึ้น

ความสงสัยและตั้งคำถามเป็นสิ่งจำเป็นเพราะระบบจับผิดส่งผลกระทบต่อชีวิตของเราทุกคน ยกตัวอย่างบอร์ดบริหารของ Toronto Police ก็มีการร่างกฏหมายควบคุมการใช้งาน AI ใหม่อีกครั้งในเดือนกันยายนปี ค.ศ.2021 หรืออย่างสำนักงานตำรวจเมืองชิคาโกก็มีการระงับใช้การใช้งานระบบอัตโนมัติทุกอย่างหลังจากมีรายงานว่ามันมีความผิดพลาดเกิดขึ้น

หน่วยงานที่บังคับใช้กฎหมาย เจ้าหน้าที่ตำรวจทุกแห่งควรให้ความสำคัญกับปัญหานี้อย่างมาก เราในฐานะประชากรก็ห้ามเพิกเฉยต่อเทคโนโลยีใหม่ๆ อย่าคิดว่าไม่สำคัญเพราะมันคือความแตกต่างระหว่างการกักขังผู้บริสุทธิ์หรือผู้กระทำผิดจริงๆ ได้เลย ระบบเก่าที่ใช้มนุษย์เต็มไปด้วยอคติ ระบบใหม่ที่สร้างขึ้นมาจากข้อมูลของระบบเก่าก็ให้ผลที่ไม่ต่างกัน เพียงแต่ครั้งนี้มันอาจจะสร้างผลกระทบที่รุนแรงและเป็นวงกว้าง แถมยังไม่รู้ว่าจะหาใครมารับผิดชอบสิ่งที่เกิดขึ้นได้รึเปล่าอีกด้วย

ยูวัล โนอาห์ แฮรารี ผู้เขียนหนังสือชื่อดังอย่าง Sapiens กล่าวเอาไว้ว่า “เราไม่ควรจดจ่อกับคำถามว่าจะหยุดยั้งความก้าวหน้าทางเทคโนโลยีได้อย่างไร เพราะนั่นเป็นไปไม่ได้ ถามว่าเราจะใช้ประโยชน์จากเทคโนโลยีใหม่ๆ อย่างไรดีกว่า ในขณะที่เรายังมีอำนาจมากเพียงพอจะกำหนดทิศทางของมัน”

เทคโนโลยีไม่มีทางหยุดพัฒนา เราเองนั่นแหละที่ต้องหาทางจัดการดูแลมันให้ได้

อ้างอิงข้อมูลจาก

Illustration by Kodchakorn Thammachart